Sadržaj

Deepfake video - tehnike detekcije

Sažetak

Poboljšanjem sklopovlja i programske potpore za izradu slika i video zapisa uvelike se olakšala i mogućnost naknadnog uređivanja istih. Jedna od brojnih metoda uređivanja video sadržaja je i deepfake metoda koja koristi umjetnu inteligenciju i strojno učenje kako bi se generirao uvjerljiv fikitvan video materijal. Najčešća uporaba deepfake metode je preslikavanje lica jedne osobe na lice druge koja se nalazi u originalnom video zapisu ili slici, a da taj novi sadržaj ljudskom oku bude u potpunosti uvjerljiv. Korištenje ove metode najčešće se povezuju sa zlonamjernom upotrebom kako bi se oštetila reputacija javne osobe, stvorila lažna informacija ili izvršila neka vrsta prevare. Zbog ovih razloga i ubrzanog razvoja kvalitete deepfake sadržaja, bitno je da se razvijaju i metode prepoznavanja uređivanog sadržaja.

Keywords: deepfake; detekcija

Uvod

U posljednjih nekoliko godina deepfake algoritmi i metode nisu samo postali vrlo razvijeni već i vrlo dostupačni. Korisnici bez ikakvog iskustva u uređivanju video sadržaja uz uporabu aplikacija kao što su FakeApp, OpenFaceSwap i drugih mogu odmah stvoriti uvjerljiv fiktivan sadržaj [1]. Motivacije i hitrosti u potrebi za razvojem uspješnih metoda razotkrivanja fiktivnog sadržaja ne nedostaje. To nam može prikazati incident s početka 2019. godine gdje su javnosti objavljene kompromitirajuće slike tadašnjeg ministra poljoprivrede Tomislava Tolušića. Sigurnosno-obavještajna agencija Republike Hrvatske utvrdila je da se radi lažnim slikama. Specijalist za obradu fotografija Karlo Toth u intervjuu za Večernji list napomenuo je moguće da se na slikama samo zamijenilo lice originalne osobe s licem ministra [2]. Iako nigdje nije spomenuta mogućnost da se radi o deepfake načinu obrade slika možemo uočiti sličnost rezultata (vrlo realistične zamjene lica dvije osobe). Trenutačno jedan od najpoznatijih primjera uporabe deepfake tehnologije su videozapisi imitacije američkog glumca Toma Cruisea [3].

Deepfake algoritmi mogu se koristiti na razne pozitivne načine: stvaranje zabavnog sadržaja, poboljšanje kvalitete filmova i sličnih sadržaja te oživljavanja slika preminulih članova obitelji [4]. Ipak, u modernim vremenima sve je teže raspoznati stvarne i nestvarne informacije, donedavno su se slike i videozapisi uzimali kao čvrsti dokazi neke informacije, a sada je njihova vjerodostojnost poljuljana. Zbog su metode detekcije vrlo bitne i neke od njih će se proučiti u nastavku.

Metode detekcije

Kao i algoritmi za stvaranje, algoritmi za detekciju deepfake sadržaja koriste umjetnu inteligenciju. Algoritmi za detekciju se mogu podijeliti u više kategorija ovisno o tome na koji način pokušavaju detektirati uređen sadržaj. Problem s takvim pristupom je neuspješnost detekcije ako deepfake nije napravljen na način kojim bi spadao u tu kategoriju. Zato je potrebno provesti detekciju s više različitih metoda detekcije.

Opće metode detekcije

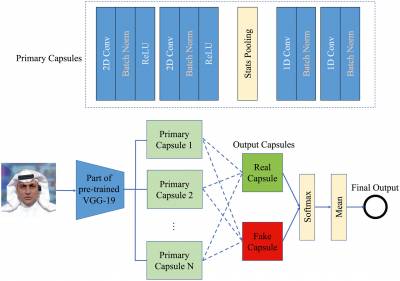

U ovoj kategoriji videosadržaj se analizira okvir po okvir. Za treniranje neuronske mreže koriste se otprije detektirani deepfake sadržaji kako bi mreža naučila raspoznavati nove uređene sadržaje. Učenje transferom bio je jedan od prvih pristupa detekcije gdje su se koristili već postojeći algoritmi za klasifikaciju slika. Negativna strana tih algoritama je sklonost preveliko prilagođavanje modelu te nemogućnost detekcije nekonzistencija između uzastopnih okvira. [5] Neuronska mreža može se postaviti i tako da raspodijeli okvir u kapsule koje analiziraju pojedinačne aspekte lica. Ovaj pristup ima bolje rezultate što je neuronska mreža dublja i razvijenija.

Ova vrsta metoda predstavlja prvi korak u detekciji deepfake video zapisa.

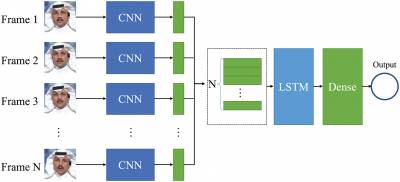

Metode detekcije vremenske konzistencije

Vremenska konzistentnost je aspekt koji imaju okviri kod videozapisa. Susjedni okviri u videozapisima su uvijek vrlo slični te će se uređivanjem videozapisa uništeno ta sličnost okvira ili dijela okvira (u području lica). Neuronske mreže za ovu vrstu detekcije prvo izvode postupak sličan prethodnoj kategoriji te rezultate pohranjuju. Nakon obrade svih okvira drugi dio mreže uspoređuje sličnosti izlaza prvog dijela te ih stavlja u vremenski kontekst te se na kraju donosi zaključak o autentičnosti videa.

Iako puno napredniji od općeg pristupa, nedostaci ovog pristupa su nemogućnost detekcije prostornih anomalija, videozapisi u kojima se događaju nagle promjene okvira (npr. izmjene kadra) i kao sa svakom neuronskom mrežom novi pristupi izradi deepfake videa.

Metode detekcije vizualnih artefakta

Mnoge metode stvaranja deepfake videa pokušavaju na originalno lice umiješati odnosno preslikati novo lice. Ovaj proces je gotovo nemoguće savršeno provesti zato što je svako ljudsko lice unikatno. Tako se na rubovima uređivanja često nalazi granica koju se može uočiti.

U ovoj kategoriji detekcije može se tražiti više nekonzistentnosti. Algoritmi se često fokusiraju na samo jedno područje, a neka od tih područja su: granica miješanja slika, nekonzistentnost u položaju aspekta lica s položajem glave te razlika u boji i rezoluciji područja glave i ostatka slike. Najizraženiji nedostatak ovih metoda je zapravo njihovo pomaganje u razvoju boljih deepfake algoritama. Kako se deepfake algoritmi poboljšavaju učeći od prethodnih detekcija tako ovi pristupi detekciji postaju neuporabivi.

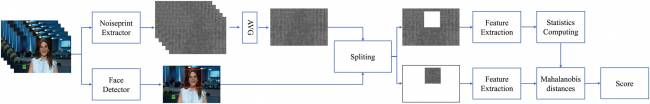

Metode zasnovane na otisku kamere

Ova skupina algoritama za detekciju se oslanja na činjenicu da je originalni video snimljen nekim uređajem dok je uređeni dio generiran digitalno. U radu [6] se predstavlja ideja da svaki uređaj za snimanje ima specifičan patent šumova koje proizvodi sklopovlje uređaja. Na osnovu ove ideje neuronske mreže se mogu istrenirati tako da prepoznaju patent šuma odnosno nedostatak istog. Međutim ova metoda zakazuje pri bilo kakvoj post obradi originalnog sadržaja. Patenti šuma mogu se preurediti ili čak generirati u algoritmima za stvaranje deepfake videa.

Metode zasnovane na biološkim signalima

Kao što je spomenuto u članu [3] najteži dio stvaranja deepfake video sadržaja je ostaviti dojam da se radi o pravoj osobi. Naime jednu sliku je urediti da izgleda uvjerljivo, ali u videu deepfake treba pokazati i ljudsko ponašanje. Analizu ponašanja najbolje mogu prosuditi sami ljudi, ali analize se mogu učiniti i iz pomoć umjetne inteligencije. U procesu stvaranja deepfakea se koriste brojne slike ljudi, a na tim slikama ljudi najčešće imaju otvorene oči i zbog toga je algoritmu teško generirati uvjerljiv treptaj. Neuronske mreže za detekciju se tako mogu samo fokusirati na oči lica te proučavati treptaje i patente treptaja.

Međutim kao i kod prethodnih metoda učestalim korištenjem ove metode poboljšat će se izrada deepfake algoritama. Najjednostavnije rješenje kako prevariti ovu metodu detekcije je dodavanje dovoljnog broja lica sa zatvorenim očima u skup slika za treniranje deepfake algoritma.

Zaključak

Razvoj metoda detekcije zahtjeva konstantu evoluciju. Savršena metoda za detekciju nikada neće biti ustanovljena jer će se uvijek moći napraviti bolji deepfake koji će prevariti i tu metodu. Daljnji razvoj ovog područja će umanjiti vjerodostojnost videozapisa kao točne informacije. Ne samo da će se za lažne videosadržaj tvrditi da su istiniti već će se moći i obratno, za istinite videosadržaje tvrditi da su lažni. Iz ovih razloga vjerujem da će se područje izrade i detekcije deepfake videa eksponencijalno razvijati u idućih nekoliko godina.